基于算力魔方与PP-OCRv5的OpenVINO智能文档识别方案

一、引言

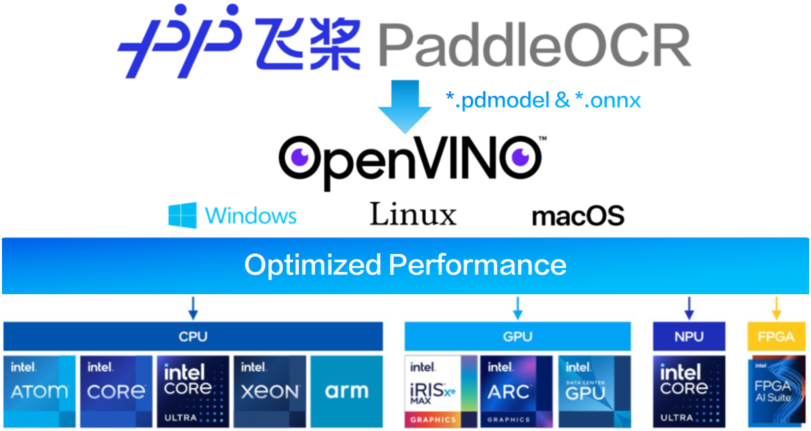

随着人工智能技术的快速发展,光学字符识别(OCR)技术已从传统的模式识别方法演进到基于深度学习的端到端解决方案。百度飞桨(PaddlePaddle)团队最新推出的PP-OCRv5模型在精度和效率上实现了显著突破,结合Intel OpenVINO工具套件的硬件加速能力,能够为各类文档处理场景提供更强大的支持。

算力魔方简介

算力魔方是一款可以DIY的迷你主机,采用了抽屉式设计,后续组装、升级、维护只需要拔插模块。通过选择不同算力的计算模块,再搭配不同的 IO 模块可以组成丰富的配置,适应不同场景。

性能不够时,可以升级计算模块提升算力;IO 接口不匹配时,可以更换 IO 模块调整功能,而无需重构整个系统。

本文以下所有步骤将在带有Intel i5-1165G7处理器的算力魔方上完成验证。

二、实施步骤

(一)准备工作

安装Miniconda并创建虚拟环境:

conda create -n PP-OCRv5_OpenVINO python=3.11 #创建虚拟环境

conda activate PP-OCRv5_OpenVINO #激活虚拟环境

python -m pip install —upgrade pip #升级pip到最新版本

pip install -r requirements.txt # 安装所需的软件包

(二)模型部署

下载并安装 PaddlePaddle 和 PaddleOCR

pip install paddlepaddle #安装paddlepaddle

pip install paddleocr

#安装paddleocr

#安装paddleocr

pip install onnx==1.16.0 #安装onnx

paddleocr install_hpi_deps cpu #调用并运行组件

(三)下载 PP-OCRv5_server 预训练模型

wget https://paddle-model-ecology.bj.bcebos.com/paddlex/official_inference_model/paddle3.0.0/PP-OCRv5_server_det_infer.tar && tar -xvf PP-OCRv5_server_det_infer.tar # 下载并解压 PP-OCRv5_server_det 预训练模型

Wget https://paddle-model-ecology.bj.bcebos.com/paddlex/official_inference_model/paddle3.0.0/PP-OCRv5_server_rec_infer.tar && tar -xvf PP-OCRv5_server_rec_infer.tar # 下载并压缩 PP-OCRv5_server_rec 预训练模型

wget https://paddle-model-ecology.bj.bcebos.com/paddlex/official_inference_model/paddle3.0.0/PP-LCNet_x1_0_doc_ori_infer.tar && tar -xvf PP-LCNet_x1_0_doc_ori_infer.tar # 下载并压缩 PP-OCRv5_server_cls 预训练模型

将 PP-OCRv5_server 模型导出至 ONNX

paddlex —paddle2onnx —paddle_model_dir ./PP-OCRv5_server_det_infer —onnx_model_dir ./PP-OCRv5_server_det_onnx

将 PP-OCRv5_server_det 导出到 ONNX

paddlex —paddle2onnx —paddle_model_dir ./PP-OCRv5_server_rec_infer —onnx_model_dir ./PP-OCRv5_server_rec_onnx

将 PP-OCRv5_server_rec 导出到 ONNX

paddlex —paddle2onnx —paddle_model_dir ./PP-LCNet_x1_0_doc_ori_infer —onnx_model_dir ./PP-OCRv5_server_cls_onnx

将 PP-OCRv5_server_cls 导出到 ONNX

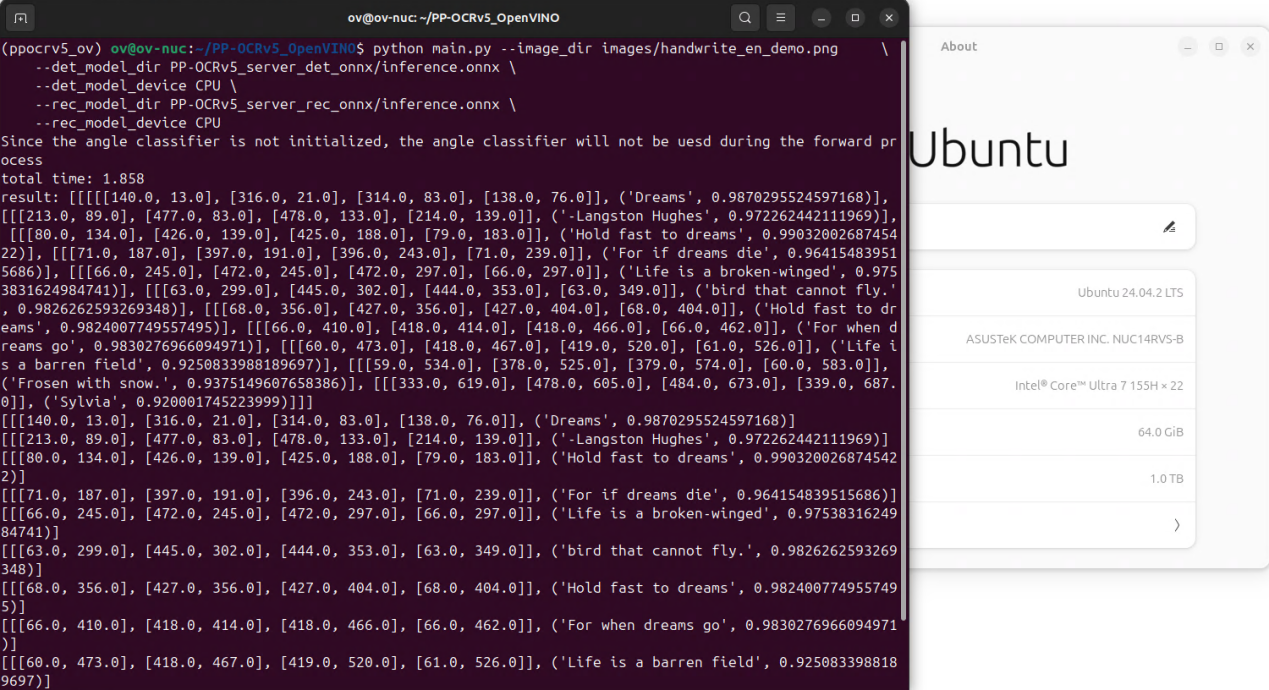

运行脚本

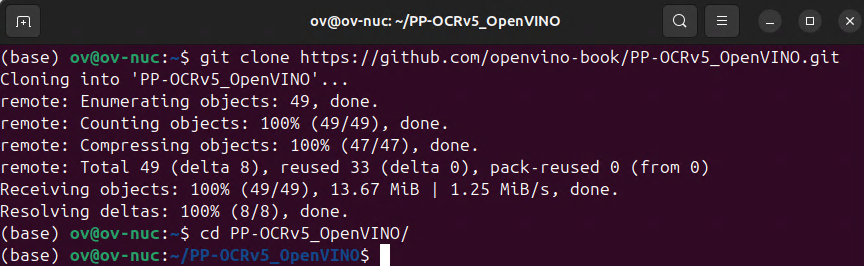

要快速开始使用 PP-OCRv5_OpenVINO 项目,请执行以下步骤:

python main.py —image_dir images/handwrite_en_demo.png \ #运行python代码调用推理

—det_model_dir PP-OCRv5_server_det_onnx/inference.onnx \

—det_model_device CPU \

—rec_model_dir PP-OCRv5_server_rec_onnx/inference.onnx \

—rec_model_device CPU

后续程序会将识别到的文本结果直接打印到控制台

三、结论

本文详细介绍了基于PP-OCRv5和OpenVINO的智能文档信息提取解决方案的部署流程。新版本的PP-OCRv5在精度和速度上都有显著提升,结合OpenVINO的硬件加速能力,能够实现高效的文档处理。该方案特别适合需要处理大量文档的企业场景,如金融票据识别、合同审核、档案数字化等应用。